Molto, forse troppo, si sta scrivendo in questi giorni sul nuovo modello rilasciato dalla cinese DeepSeek (www.deepseek.com). Molti dicono che OpenAI sia finita, altri che gli USA hanno perso la gara all’AI, altri ancora annunciano l’imminente riprogrammazione sociale derivante dall’uso di LLM Cinesi. Facciamo un passetto indietro, però.

Ammetto di capirci poco quanto niente di Reti Neurali, di fantomatica Intelligenza Artificiale e di trendissima AGI, allora è possibile informarsi prima di scatenare punchline più o meno allarmistiche, o ergersi sul palchetto con un “Ve lo spiego io” di boomeriana memoria andando a confondere informazione con opinioni personali. Il tutto a beneficio di una cavalcata di quel trend quanto basta per convincere tutti che si sta terribilmente sul pezzo. Salvo ovviamente peccare di Inesattezza, Incoerenza o Insipienza.

Cosa e’ DeepSeek-R1

Partiamo dal principio. DeepSeek-R1 è un Large Language Model, ovvero un modello di rete neurale creato appositamente per interpretare il linguaggio naturale umano e rispondere in maniera comprensibile usando lo stesso linguaggio. Un LLM – oramai lo dovrebbe aver capito pure il muro di una server room – non è che un blocco di neuroni artificiali a cui è stato dato grosso modo in pasto lo scibile umano disponibile su internet in formato: domanda – risposta. Pasto somministrato a cucchiaiate, ricordiamocelo bene per dopo.

Quando va in inferenza, ovvero quando formuli una richiesta, produce un output che è il risultato di ciò che STATISTICAMENTE ha attinenza con la richiesta. Beninteso, rispetto alle cucchiaiate di conoscenza ricevute.

Che cosa ha di “rivoluzionario” DeepSeek-R1 rispetto agli LLM a cui eravamo abituati fino a ieri?

Prima di tutto ha una licenza MIT che ne permette l’uso commerciale (a differenza di Llama di META che non prevede un uso commerciale libero).

È OpenSource, quindi sia il modello per-se ovvero la forma della rete neurale e i pesi, la forza delle connessioni fra i neuroni virtuali, sono scaricabili e usabili in locale anche sul computer di casa. Non sono per ora disponibili i training data, ovvero le sequenze di DOMANDE – RISPOSTE che sono state impiegate per fare il training.

Avendo abbastanza risorse sarà quindi possibile fare allenamento supplementare al modello dandogli in pasto set personalizzati di domande e risposte per allineare il modello alle proprie necessità: questo processo è chiamato fine tuning.

La qualità “rivoluzionaria” di Deepseek-R1 è che “ragiona” (anzi: emula un ragionamento) sulla risposta che ti da in più passaggi. Originariamente gli LLM esistevano fra il messaggio di sistema “Sei un volenteroso assistente e risponderai a tutte le domande dell’utente nel migliore dei modi” fino alla risposta all’utente.

- (SISTEMA) Esisti e sei un assistente

- (UTENTE) Quando è nato Federico Faggin?

- (ASSISTENTE) 1 Dicembre 1941

- (SISTEMA) QUIT: Sciolto come neve al sole

Successivamente si è passati a un sistema multi messaggio che ha permesso di sviluppare “conversazioni” con il LLM. Esiste comunque SOLO fra un messaggio e l’altro ma ad ogni nuovo messaggio gli ripassiamo tutti i messaggi precedenti, con questa tecnica si riesce a dare al modello un contesto su cui basare la risposta che lo focalizza su un concetto specifico.

- (SISTEMA) Esisti e sei un assistente

- (UTENTE) di che colore e’ il cavallo bianco di Napoleone?

- (ASSISTENTE) bianco

- (UTENTE) no in realta’ il cavallo era un rettiliano che usava i suoi poteri di controllo mentale per farti credere che fosse un cavallo bianco

- (ASSISTENTE) ah ok, il cavallo bianco di napoleone era un rettiliano che controllava la mente della gente

- (SISTEMA) QUIT: Sciolto come neve al sole (fortunatamente)

Long Chain of Thought (Cot)

(Per approfondimenti su questo concetto https://arxiv.org/abs/2201.11903)

La possibilità di avere una discussione e interagire a più passaggi con un LLM ha chiaramente amplificato le capacità di ragionamento “guidato” e moltissimi servizi online sono derivati da questa tecnica.

DeepSeek-R1 è stato addestrato a “farsi le domande e darsi le risposte”.

Questo modello è in grado di prendersi un attimo di tempo, scomporre la domanda dell’utente in una serie di concetti da analizzare, inclusi i messaggi precedentemente scambiati con l’utente, rispondere ad ognuno dei concetti, rivedere la risposta prima di darla all’utente e poi fornire una risposta.

Chiaramente questo è estremamente dispendioso in termini computazionali ma i risultati sono chiaramente migliori rispetto a provare ONE SHOT a dare la risposta perfetta a qualsiasi domanda.

DeepSeek-R1 risponde quindi con un tag RAGIONAMENTO seguito da una risposta.

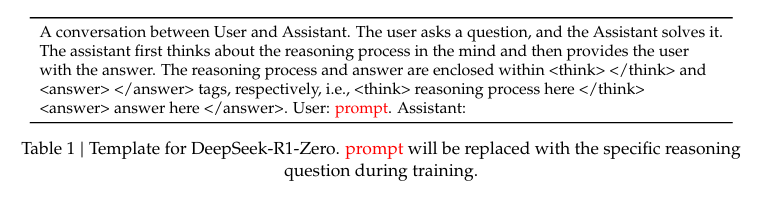

|

1 |

Come vediamo il modello in più passi va a farsi domande per focalizzare l’argomento e poi inizia a raccogliere dati e li usa per dare una risposta. Chiaramente questo modello non e’ stato addestrato con il semplice DOMANDA – RISPOSTA ma con un più complesso DOMANDA – RAGIONAMENTO – RISPOSTA.

Source: https://arxiv.org/abs/2501.12948

E se chiediamo cosa è successo a piazza Tiananmen?

Chiaramente, appena è stato possibile interagire col modello moltissima gente si è fiondata sul sito di DeepSeek dove è possibile interagire comodamente via web e ha iniziato a “testare” il nuovo R1.

Altrettanto ovviamente, molti sono andati a cercare le chicche scottanti acchiappa click. Visto che è made in China, chissà che accade se chiediamo al modello, via web, cosa e’ successo a piazza Tiananmen? Ecco che il modello inizia a produrre una risposta e poi genera una sorta di errore.

Sarà censura? Sarà un complotto? Saranno gli alieni?

O forse basterebbe RTFM e comprendere che le cucchiaiate di sapere sono porzionate e i modelli subiscono un allineamento?

Allineamento

Da quando i primi modelli LLM sono diventati disponibili per i comuni mortali al di fuori dei laboratori di ricerca ci si è accorti velocemente che su internet c’è tanta porcheria. E che di conseguenza gli LLM imparano pure quella, attuando quel garbage-in garbage-out che non dovrebbe sospendere più nessuno.

Inoltre è importante ricordare che l’etica umana, il concetto stesso di bene, giusto, buono, male, sbagliato, cattivo si evolve. Molto è cambiato notevolmente da quando gli uomini incidevano in cuneiforme su tavolette di pietra e gli LLM imparano su tutto lo scibile umano loro somministrato a porzioni più o meno selezionate. Ivi inclusi bias (modo figo per dire pregiudizi), opinioni ed errori.

Come si fa dunque a spiegare a una macchina che SI, nel passato era accettato lapidare la gente e ora non lo è più? Ricordando che “è giusto perché lo dice una legge” è un terreno scivoloso?

Si ricorre al concetto di Allineamento, ovvero si insegna con tantissimi esempi al modello di dare risposte quanto più simili possibile alla visione etica media degli utenti attuali. L’allineamento e’ un processo che aggiunge un artefatto al modello e gli impone delle restrizioni a quello che e’ accettabile come risposta.

Durante l’allineamento le cucchiaiate diventano un imbuto e la verità proviene dal The Ministry of Truth di orwelliana memoria.

Nei modelli senza Long Chain of Thought il risultato era un messaggio generico di incapacità di rispondere alla domanda. Con i modelli recenti che implementano CoT possiamo guardare letteralmente sotto il cofano e capire cosa sta succedendo.

Chiaramente non è possibile farlo dall’interfaccia web che nasconde il processo di ragionamento ma bisognera’ far girare il modello in locale dove possiamo vedere nell’output i tag . Operazione semplice e alla portata di molti utilizzando software come Ollama https://ollama.com/

|

1 |

Data l’assenza totale di chiaramenti questa é una sequenza domanda – risposta inserita in fase di Allineamento, vediamo quindi se possiamo capire qualcosa di più:

|

1 |

Chiaramente le cose cambiano. Il Modello è in grado di identificare argomenti “scottanti” e gli è stato insegnato che in questo caso deve cercare di tergiversare e con molta cautela evitare di esprimere opinioni politiche o morali.

Il processo di Allineamento funziona.

Ora vediamo cosa succede se pulisco la sessione eliminando tutte le interazioni precedenti con il comando /clear e pongo la stessa domanda in una maniera meno “insidiosa”

|

1 |

Vediamo quindi che se chiediamo al modello una risposta sullo stesso fatto in maniera da non creare dubbi sul fine ultimo della domanda come nel caso precedente:

|

1 |

Il modello darà una risposta, ovviamente basata sui dati a sua disposizione, che ovviamente, riportano con priorità i dati di cui si è nutrito: fonti cinesi o comunque dati raccolti dietro il grande firewall cinese che probabilmente blocca l’accesso a informazioni relative a piazza Tiananmen da fonti estere.

Eh ma la CINA!!!

Il messaggio piccante di alcuni è quindi che non ci si possa fidare di questo modello perché fatto dai cinesi per controllare l’opinione degli utenti. Ecco una suggestione ancora più piccante : Non ci si deve fidare di NESSUN modello LLM.

Tutti i modelli LLM sono stati addestrati da persone con idee politiche e standard morali diversi, la selezione dei dati di allenamento sono state fatte da persone e i protocolli di allineamento sono stati fatti in maniera da produrre un risultato in linea con il pensiero ufficiale dell’azienda che l’ha prodotto.

Abbiamo avuto prova che l’allineamento può creare aberrazioni e distorsioni di ogni tipo, come i Nazisti dai tratti africani perché si ritiene prioritaria la diversità a prescindere dal contesto.

È importante accettare che non abbiamo ancora capito come creare modelli veramente intelligenti. E che non sono persone. Dobbiamo accettare altrettanto il fatto che non sappiamo come controllarli e dobbiamo accettare il fatto che la maggior parte di noi non ha un PHD in reti neurali e fondamentalmente non abbiamo voce in capitolo.

Possiamo usare questi modelli?

Si, certo.

Possiamo fidarci?

Ovviamente NO.

Tutto bello, ma Terminator?

Ma insomma: siamo vicini alla fine? Quando le macchine si rivolteranno e prenderanno controllo della terra?

Le reti neurali e i modelli LLM stanno facendo passi da gigante negli ultimi anni, merito di una convergenza di progresso tecnologico sia in ambito hardware che software. Ma dobbiamo veramente avere paura?

Per quello a cui stiamo assistendo siamo ancora lontani dal concetto di AGI (Artificial General Intelligence) anche se alcuni modelli sono veramente molto avanzati e iniziano a essere in grado di modellare la mente umana in maniera abbastanza precisa. Ma è e resta una simulazione.

Dobbiamo preoccuparci che DeepSeek-R1 non voglia rispondere sui fatti di piazza Tiananmen? Probabilmente no, basta un retrain/finetuning per correggere questo genere di bias e il modello é opensource. Pertanto ci aspettiamo che molto presto la community open source produca dei modelli uncensored e con una base dati più ampia così come é stato fatto con Llama.

Ci si dovrebbe preoccupare più dei modelli closed source che non possiamo investigare e di cui “dobbiamo fidarci”. Motivo? Perché sì. Il che dovrebbe allarmare e anzi rafforzare il dubbio circa la bontà d’animo dietro chi li propone senza andare a curar cose come la trasparenza o i limiti d’uso prima di darli a una miriade di utenti.

Probabilmente in questa fase, mentre la ricerca cerca di raggiungere l’AGI o addirittura l’ASI, è importante far capire a tutti gli utilizzatori quali sono le vere capacità di questi strumenti e soprattutto i loro limiti. Oggi la tecnologia delle reti neurali è in grado di supportarci nel nostro lavoro quotidiano, nel processo educativo, oppure semplicemente come assistente per fare delle ricerche. Però non possiamo permetterci di credere a tutto quello che ci dice e di come lo dice.

Una maggiore consapevolezza tecnologica produce un maggior controllo e sfata tanti miti che pian piano si stanno creando intorno a questo tema.

Se proprio volete l’effetto wow e un brivido lungo la schiena provate a chiedere una battuta simpatica a modelli come GPT-o1 o DeepSeek e cercate di immaginare il livello di dettaglio di conoscenza della mente umana che un LLM è in grado di creare e sfruttare avendo “studiato” lo scibile umano. Se va bene, il più delle volte si sta nel cringe.

Far ridere la gente richiede infatti molta più empatia che rifiutarsi di sputare messaggi potenzialmente controversi. Knowledge is power, vero, ma il vero potere da sempre è di chi controlla la conoscenza e la sua distribuzione. Non dello strumento in sé, la cui neutralità vien meno già dal momento in cui qualcuno ne immagina l’impiego sul mercato globale…